内容

资料来源:Vs1489 / Dreamstime.com

带走:

“深度学习”只是高级神经网络的另一个名称,还是比它还多?我们来看看深度学习以及神经网络的最新进展。

怀疑论者俱乐部

如果您和我一样属于怀疑论者俱乐部,那么您可能还想知道深度学习有什么大惊小怪的。神经网络(NNs)并不是一个新概念。多层感知器于1961年推出,而不仅仅是昨天。

但是当前的神经网络比多层感知器还复杂。它们可以具有更多的隐藏层,甚至可以重复连接。但是,等等,他们仍然不使用反向传播算法进行训练吗?

是!现在,计算机的计算能力已无法与20世纪60年代甚至80年代的能力相提并论。这意味着可以在合理的时间内训练更为复杂的神经体系结构。

因此,如果这个概念不是新概念,那么这是否意味着深度学习只是类固醇上的一堆神经网络?所有这些大惊小怪仅仅是因为并行计算和功能更强大的机器吗?通常,当我研究所谓的深度学习解决方案时,情况就是这样。 (神经网络在现实世界中有哪些实际用途?在5个神经网络用例中查找可帮助您更好地理解该技术的案例。)

正如我所说,尽管我属于怀疑论者俱乐部,但我通常对尚未得到支持的证据保持警惕。暂时,让我们抛开偏见,让我们尝试对神经网络方面的深度学习中的新兴技术(如果有)进行彻底的研究。

当深入研究时,我们确实在深度学习领域找到了一些新的单元,架构和技术。其中一些创新的权重较小,例如,辍学层引入的随机化。但是,另一些则负责更重要的更改。而且,可以肯定的是,它们中的大多数依赖于较大的计算资源可用性,因为它们在计算上相当昂贵。

在我看来,神经网络领域的三项主要创新为深度学习获得了当下的流行做出了巨大贡献:卷积神经网络(CNN),长短期记忆(LSTM)单元和生成对抗网络(GAN) )。

卷积神经网络(CNN)

深度学习的大爆炸-至少在我第一次听到这种热潮的时候-发生在图像识别项目中,即2012年ImageNet大规模视觉识别挑战赛。为了自动识别图像,一个卷积神经网络使用了八层AlexNet。前五层是卷积层,其中一些紧随其后是最大池化层,后三层是完全连接的层,所有层均具有非饱和ReLU激活功能。 AlexNet网络的前五名错误率为15.3%,比第二名的错误率低10.8个百分点。这是一个巨大的成就!

没有错误,没有压力-在不破坏生活的情况下创建可改变生活的软件的分步指南

当没有人关心软件质量时,您就无法提高编程技能。

除了多层体系结构之外,AlexNet的最大创新是卷积层。

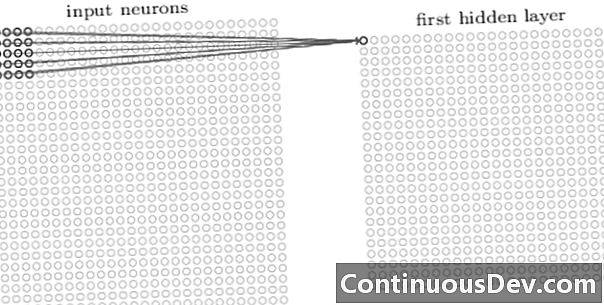

卷积网络中的第一层始终是卷积层。卷积层中的每个神经元都聚焦在输入图像的特定区域(接收场)上,并通过其加权连接充当接收场的过滤器。在所有图像接收场上滑动过滤器(在神经元之后,在神经元之后),卷积层的输出会生成激活图或特征图,可以用作特征标识符。

通过在彼此之上添加更多的卷积层,激活图可以表示来自输入图像的越来越多的复杂特征。此外,在卷积神经网络体系结构中,通常在所有这些卷积层之间散布一些其他层,以增加映射函数的非线性度,提高网络的鲁棒性并控制过度拟合。

现在我们可以从输入图像中检测出高级特征,我们可以在网络的末端添加一个或多个完全连接的层以进行传统分类。网络的最后一部分将卷积层的输出作为输入,并输出一个N维向量,其中N是类数。此N维向量中的每个数字代表一类的概率。

回想过去,我经常听到对神经网络的反对意见,即神经网络的架构缺乏透明度以及无法解释和解释结果。如今,与深度学习网络相关的反对越来越少。看起来现在可以接受黑盒效应以换取更高的分类精度了。

长短期记忆(LSTM)单位

通过递归神经网络(RNN)在时间序列分析中可以看到深度学习神经网络带来的另一项重大改进。

递归神经网络并不是一个新概念。它们已经在90年代使用过,并经过了时间反向传播(BPTT)算法的培训。不过,在90年代,鉴于所需的计算资源量,通常无法对其进行培训。但是,如今,由于可用计算能力的提高,不仅可以训练RNN,而且可以增加其体系结构的复杂性。这就是全部?好吧,当然不会。

1997年,引入了一种特殊的神经单元,以更好地处理时间序列中相关过去的记忆:LSTM单元。通过内部门的组合,LSTM单元能够记住相关的过去信息或忘记时间序列中不相关的过去内容。 LSTM网络是一种特殊类型的递归神经网络,包括LSTM单元。基于LSTM的RNN的展开版本如图2所示。

为了克服有限的长存储功能的问题,LSTM单元使用了额外的隐藏状态–单元状态 C(吨) –源自原始的隐藏状态 H T)。 C(吨) 代表网络内存。一种称为门的特殊结构允许您删除(忘记)或添加(记住)信息到单元状态 C(吨) 在每个时间步基于输入值 设 和以前的隐藏状态 h(t-1)。每个门通过输出0到1之间的值来决定要添加或删除的信息。 C(t-1),信息将被删除(gate的输出= 0)或保留(gate的输出= 1)。

在图2中,我们看到了LSTM单元的网络结构。每个LSTM单元都有三个门。开始时的“忘记门层”从先前的单元状态中滤除信息 C(t-1) 根据当前输入 设 和上一个单元格的隐藏状态 h(t-1)。接下来,“输入栅极层”和“ tanh层”的组合决定要添加到先前已过滤的单元状态的信息 C(t-1)。最后,最后一个门,即“输出门”,从更新后的单元状态决定哪个信息 C(吨) 最终进入下一个隐藏状态 H T).

有关LSTM单位的更多详细信息,请查看Christopher Olah的GitHub博客文章“ Understanding LSTM Networks”。

图2. LSTM细胞的结构(摘自Ian Goodfellow,Yoshua Bengio和Aaron Courville的“深度学习”)。注意LSTM单元内的三个门。从左到右:忘记门,输入门和输出门。

LSTM单位已成功用于许多时间序列预测问题,但尤其是在语音识别,自然语言处理(NLP)和自由生成中。

生成对抗网络(GAN)

生成对抗网络(GAN)由两个深度学习网络(生成器和鉴别器)组成。

发电机 G 是一种转换输入噪声的转换 ž 成张量(通常是图像) X (X= G(ž))。 DCGAN是发电机网络中最受欢迎的设计之一。在CycleGAN网络中,生成器执行多个转置卷积以上采样 ž 最终生成图像 X (图3)。

生成的图像 X 然后将其馈入鉴别器网络。鉴别器网络检查训练集中的真实图像和生成器网络生成的图像,并产生输出 D(X),这是图像的概率 X 是真实的。

生成器和鉴别器均使用反向传播算法进行训练以生成 D(X)=1 用于生成的图像。两个网络都经过交替训练以竞争以提高自身水平。 GAN模型最终会收敛并生成看起来真实的图像。

GAN已成功地应用于图像张量,以创建动画,人物甚至是梵高之类的杰作。 (有关神经网络的其他现代用法,请参见可归因于人工神经网络的6大进步。)

结论

那么,深度学习仅仅是一堆关于类固醇的神经网络吗?部分地。

不可否认,更快的硬件性能在很大程度上有助于成功训练更复杂,多层甚至是递归的神经体系结构,但是,在某些领域提出了许多新的创新性神经单元和体系结构,这也是事实。现在称为深度学习。

特别是,我们已经将CNN,LSTM单元和GAN中的卷积层确定为图像处理,时间序列分析和自由生成领域中一些最有意义的创新。

此时,剩下要做的唯一事情就是更深入地学习,并进一步了解深度学习网络如何为我们自身的数据问题提供强大的新解决方案来帮助我们。